Pronti per l'era dei Big Data?

Oggi non sentiamo altro che la parola “dati”, sono ovunque e tutti lottano per averli, un po’ come era successo con il lievito per la pizza durante una certa pandemia che tutti sicuramente ricordiamo.

Da parte delle aziende i dati che esse acquisiscono e gestiscono sono il patrimonio più grande in loro possesso “Data is the new oil!” direbbe qualcuno.

Indipendentemente dal loro settore d’appartenenza e dimensione, le aziende si trovano quotidianamente a fare i conti con questa realtà e con una mole di dati sempre maggiore. Ma cosa sono i dati aziendali e perché assumono sempre maggiore importanza all’interno della realtà aziendale?

Occorre mettere i puntini sulle “i” e precisare che i dati hanno una valenza diversa a seconda che a fruirli sia una figura aziendale piuttosto che un’altra. Un esempio possono essere i manager, per i quali le informazioni aziendali rappresentano il punto di partenza per prendere decisioni strategiche che coinvolgono l’intera azienda. Ma anche le unità operative utilizzano i dati ogni giorno nel loro ruolo, un esempio che abbiamo toccato da vicino con alcuni nostri clienti può essere l’utilizzo dei dati per eseguire l’analisi della loro attività produttiva. Il Gantt che segue, incorporato all’interno del MES di SolidRules, è uno dei grafici che utilizziamo abitualmente per schedulare in maniera efficiente le attività del reparto produttivo.

La variabilità nell’utilizzo e nell’interpretazione dei dati ha, però, un punto in comune apparentemente intangibile: la necessità di disporre di informazioni concrete che aiutino i diversi attori aziendali a prendere decisioni consapevoli e non basate sul presentimento o favorevole allineamento dei pianeti. In questo senso, le informazioni devono essere paragonate al pari di un qualsiasi altro asset societario, senza le quali non è possibile svolgere agevolmente l’attività aziendale nella quotidianità. Il punto cruciale è quindi reperire tali informazioni, nonché il contesto in cui si sviluppa la raccolta dei dati.

In altri termini, per favorire l’acquisizione di informazioni a partire dai dati aziendali è necessario considerare anche le fonti di provenienza dei medesimi, che si dividono in fonti esterne e fonti interne, quest’ultime possono a loro volta essere composte da fonti operazionali e da Data Warehouse.

Dove possiamo reperire le informazioni?

Ok, a questo punto abbiamo capito che i dati sono importanti, ma come trovarli e renderli utili per gli scopi aziendali? Ecco ti sveliamo che qui la questione si fa piccante e che esistono diversi modi in cui trovare questi famigerati dati.

Iniziamo dalle fonti operazionali. Esse fanno riferimento all’attività operativa quotidiana dell’azienda e, di conseguenza, mutano e si adattano in funzione del suo business. Questa notevole specificità alla realtà aziendale che si analizza, rende questa tipologia di fonte solamente in parte sovrapponibile a contesti aziendali di settori diversi. Un esempio di fonti operazionali relative a un’industria può includere gli applicativi di gestione della produzione, quelli di gestione degli acquisti, degli ordini e delle consegne; quelli di contabilità e di gestione del personale oltre agli applicativi di gestione dei clienti.

I Data Warehouse sono invece archivi informatici di tipo data management che raccolgono tutti i dati di un’organizzazione, e il loro scopo è rappresentare il punto di partenza sul quale produrre agevolmente le analisi e le relazioni finalizzate ai processi decisionali e strategici dell’azienda.

Questa raccolta organizzata del patrimonio informativo di un’impresa è garantita da quel sistema di modelli, metodi, processi, persone e strumenti chiamato Business Intelligence, in particolare gli analytics.

Le fonti esterne dei dati aziendali fanno riferimento ai dati che provengono dall’esterno, come per esempio i dati provenienti da indagini ISTAT oppure l’analisi del sentiment per comprendere l’opinione di un target di riferimento nei confronti di una specifica tematica, un prodotto o servizio. In quest’ultimo caso i social network, i blog e i forum online possono rappresentare una fonte dalla quale reperire importanti informazioni, anche se i dati provenienti da questo tipo di fonti esterne potrebbero presentare qualche problema di qualità, inteso come difetto di accuratezza, coerenza e/o completezza del dato.

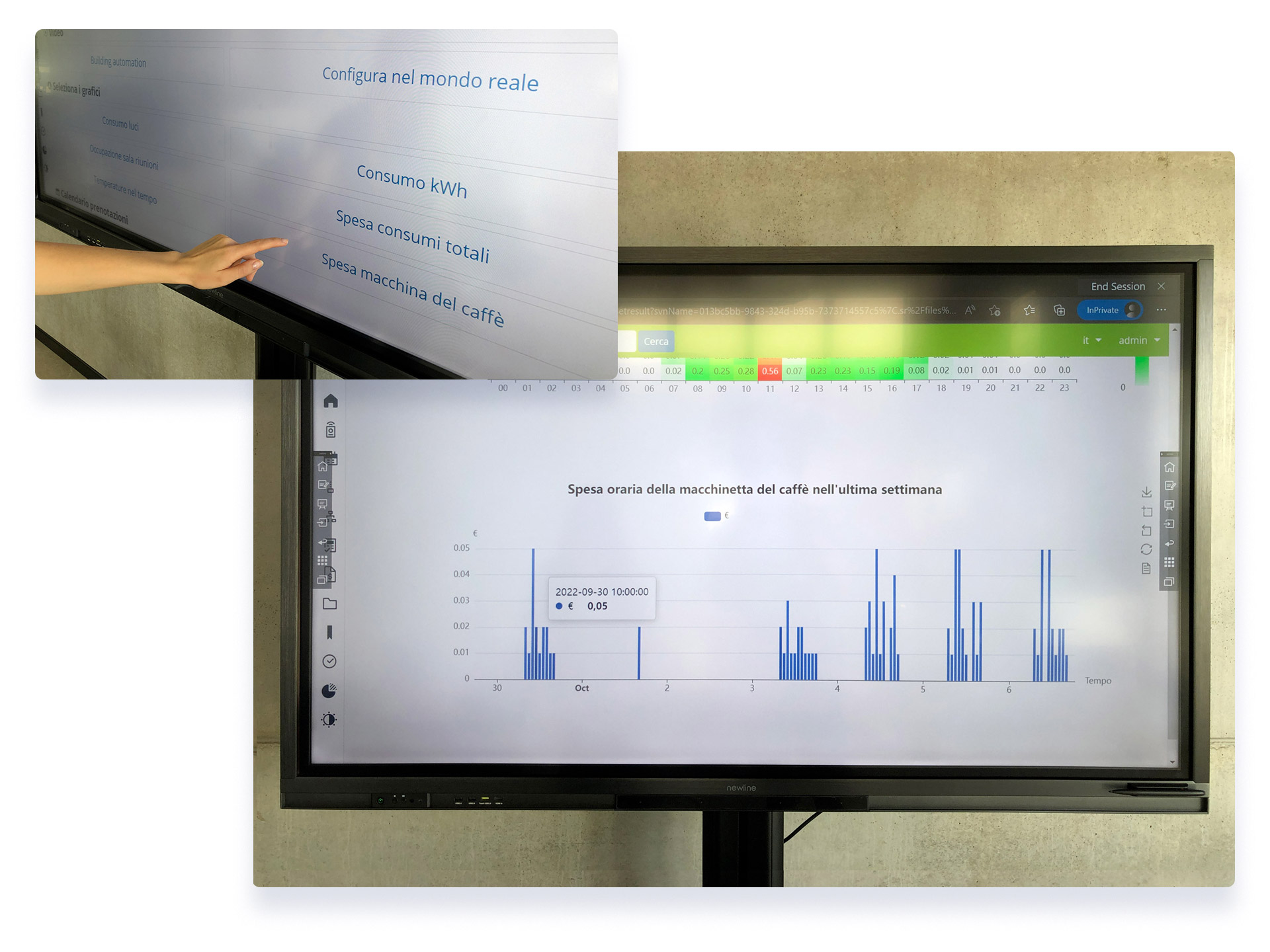

Un esempio di fonti interne lo potete osservare qui sotto. State guardando un’importante analisi svolta dal nostro Quantum su un tema di importanza vitale in una azienda di software. Il consumo della macchinetta del caffè, che, come potete notare sicuramente non senza stupore raggiunge i suoi picchi il lunedì mattina. Chi l’avrebbe mai detto?

Cosa sono i Big Data?

In un mondo in continua evoluzione, la disponibilità di una quantità di dati sempre maggiore provenienti da diverse fonti sfocia nei cosiddetti big data. Il termine big data si utilizza tipicamente per fare riferimento sia a dati che superano i limiti dei database tradizionali, sia alle tecnologie finalizzate ad estrarre da essi nuova conoscenza e valore. In sintesi, è possibile definire i big data come l’analisi di quantità incredibilmente grandi di informazioni.

I Big Data possono essere di tipo:

• Strutturato: ovvero dati che possono essere elaborati, archiviati e recuperati in un formato fisso. Sono informazioni altamente organizzate che possono essere archiviate e facilmente accessibili. I dati strutturati sono, ad esempio, le informazioni che un'azienda conserva nei propri database, come tabelle e fogli di calcolo, dove le informazioni sono raggruppate solitamente in righe e colonne. Il valore aziendale che deriva da essi risiede nel modo in cui un'organizzazione può utilizzare i propri sistemi e processi esistenti ai fini di analisi.

• Non strutturato: si riferiscono ai dati non organizzati, privi di qualsiasi forma o struttura specifica. I dati non strutturati includono generalmente commenti sui social media, tweet, condivisioni, post, audio, video… A differenza dei dati strutturati, che vengono archiviati nei Data Warehouse, i dati non strutturati vengono solitamente inseriti nei Data Lake, che conservano il formato grezzo dei dati e tutte le informazioni che contengono.

• Semi-strutturato: riguardano i dati contenenti entrambi i formati, ovvero dati strutturati e non strutturati. Si riferisce ai dati che, sebbene non siano stati classificati in un particolare repository, contengono tuttavia informazioni vitali o tag che isolano i singoli elementi all'interno dei dati. Alcuni esempi di dati semi-strutturati includono XML e JSON.

Le 6 “V” Dei Big Data

Le principali caratteristiche dei big data sono definite dalle tre "V" all’interno del modello di Doug Laney (2001):

• Volume: fa riferimento al volume di dati, quindi alla quantità di dati disponibili. Come anticipato in precedenza, le aziende raccolgono dati da un elevato numero di fonti, includendo transazioni, dati dai social media e informazioni di vario tipo.

• Velocità: fa riferimento alla velocità di generazione e trasmissione dei dati. Essi vengono trasmessi ormai ad una velocità senza precedenti e devono essere anche trattati in modo tempestivo.

• Varietà: tra gli addetti ai lavori si afferma “More isn’t just more. More is different”. I dati hanno una natura eterogenea e presentano tante tipologie di formato ed estensioni; possono essere numerici e strutturati nei classici database, documenti di testo non strutturati, documenti, audio, e-mail e video. Non solo sistemi transazionali e gestionali aziendali, ma anche sensori, social network, open data.

Oggi, in un mondo in continua espansione tecnologica e non solo, il modello in questione è stato arricchito di altre tre "V":

• Veridicità: si parla di “Bad data is worse than no data”. La veridicità deve essere intesa come caratteristica intrinseca del dato analizzato. Questo aspetto è fondamentale e merita notevole considerazione, altrimenti si corre il rischio di utilizzare dati inquinati che, in seguito al processo di analisi, restituiscono informazioni inattendibili e distorte.

• Variabilità: l’interpretazione del dato può variare in funzione dell’ambito in cui questo viene raccolto ed analizzato. Assume rilevanza il contesto da cui il dato si ricava.

• Valore: ovvero la capacità di ricavare insight e quindi benefici. La ricchezza informativa che sta dietro ai dati rappresenta il loro valore. È importante sapere trasformare correttamente il dato in valore. A tal proposito, bisogna definire con chiarezza quali sono gli elementi che caratterizzano il dato stesso (qualità del dato).

In considerazione delle sei "V", i big data richiedono tecnologie e metodi analitici specifici che possano portare all’estrazione di valori e informazioni di interesse piuttosto rilevanti.

Perché i Big Data sono importanti?

L’importanza dei Big Data non risiede nella quantità di dati che si possiedono, quanto nell’utilizzo che si può fare con questi e nell’abilità di estrarre informazioni da questi. Big Data significa quindi possedere dati da qualsiasi fonte e analizzarli per numerosi aspetti come: riduzione dei costi, riduzione dei tempi, sviluppi del prodotto e offerte mirate per i clienti e, in ottica proattiva, decisioni strategiche da prendere.

In altre parole, generare nuova conoscenza è estremamente utile per prendere decisioni più consapevoli in ambito di business e non solo. I Big Data hanno impatto in tutti i processi: dall’efficienza dei processi produttivi, alla gestione della clientela e della comunicazione con essa, fino alla gestione dei flussi e degli imprevisti, che potrebbero tradursi in emergenze da risolvere tempestivamente.

Nel grafico qui sotto, per esempio, puoi osservare una heat map che mostra l’impegno complessivo per ciascuna risorsa aziendale. In questo modo è possibile comprendere all’istante se le risorse vengono o meno sovra-allocate.

Il sistema misura l’allocazione tenendo conto delle ore stimate a completamento rapportate con quelle disponibili (in base al calendario aziendale piuttosto che riunioni, ferie, interventi).

Questo è importante per valutare l’efficienza dell’organizzazione dei processi aziendali.

I Big Data e la Business Intelligence

La business intelligence è rivolta alla descriptive analytics che rappresenta il primo livello di analisi avanzata dei dati. In particolare, si utilizza la statistica descrittiva per analizzare, misurare e valutare informazioni, utilizzando dataset puliti, limitati e, in generale, corretti da tutte quelle anomalie che si potrebbero ottenere in fase di raccolta dati. In questo modo si ottiene una fotografia presente o passata, ovvero una rappresentazione dettagliata e piuttosto fedele della realtà esaminata, per favorire il processo decisionale. In sintesi, dà priorità al riepilogo dei dati storici e attuali, per mostrare gli eventi passati o in corso, rispondendo alla domanda “cosa” e “come”.

I Big Data utilizzano invece la statistica inferenziale e concetti di identificazione di sistemi non lineari per analizzare regressioni, effetti causali e relazioni da insiemi di dati di dimensioni enormi. Inoltre, si affidano a modelli predittivi complessi e dataset eterogenei non correlati tra loro, per enfatizzare i rapporti e le dipendenze di questi dati, con successive analisi previsive il più possibile accurate e precise.

La Business Intelligence e il cubo OLAP

Una delle componenti fondamentali all’interno della Business Intelligence è il cubo olap, chiamato anche ipercubo, se si fa riferimento a tre o più dimensioni per analizzare e organizzare i dati.

In altre parole, il termine OLAP (On-Line Analytical Processing, traducibile letteralmente come “processo di analisi online”), si riferisce a un approccio utilizzato per eseguire query che coinvolgono più dimensioni, permettendo una risposta in tempi molto più rapidi rispetto ad un’interrogazione di un database transazionale. La multidimensionalità messa a disposizione dalla metodologia olap è uno dei principali punti di forza e rappresenta un buon compromesso tra il Data Warehouse e l’utente finale, fornendo a quest’ultimo una modalità intuitiva, semplice, interattiva ed estremamente performante per analizzare grandi quantità di dati. In sintesi, i principali vantaggi di un cubo olap sono:

• Performance, velocità nell’esecuzione di query mostrando dati aggiornati e aggregati in tempi brevi.

• Multidimensionalità, ovvero analisi su due o più dimensioni.

• Semplicità di utilizzo, senza effettuare complesse elaborazioni e calcoli. L’usabilità per l’utente è semplice e non richiede particolari conoscenze tecniche pregresse.

• Dettaglio di analisi, possibilità di rappresentazione dei dati con un diverso livello di analisi, dalla massima aggregazione al dettaglio più meticoloso.

Tutte queste caratteristiche inducono l’olap a essere impiegato dalle aziende per l’analisi dei risultati delle vendite e delle campagne di marketing, per la gestione della produzione, per la valutazione dell’andamento dei costi e dei ricavi e altre operazioni essenziali alle attività quotidiane dell’impresa. È quindi uno strumento di Business Intelligence che ha lo scopo di utilizzare le informazioni ottenute a supporto delle decisioni aziendali, tramite strumenti tipici di reportistica e di data visualization. E se volessimo spingerci oltre alla mera lettura di dati che guidano le decisioni? Esistono strumenti che ci consentono, per esempio, di raccogliere, studiare e analizzare le informazioni in tempo reale, predicendo comportamenti e trend futuri?

Nella schermata in basso puoi osservare un esempio di OLAP che sintetizza alcune informazioni più rilevanti riguardo alla gestione dei ticket mediante anche l’utilizzo di alcuni KPI (Key Performance Indicators) considerati importanti che devono essere consultabili immediatamente per capire se si è in linea con il raggiungimento degli obiettivi aziendali prefissati.

Le Big Data Analytics

I Big Data non possono essere analizzati con i tradizionali RDBMS (Relational Database Management System), poiché questi ultimi non sono in grado di gestirne l’archiviazione e l’analisi in velocità. Basti pensare ai dati provenienti da Internet, dai social network, dai dispositivi IoT (Internet of Things) e dall’industrial Internet of Things (IIoT). Le fonti di dati sono tantissime e in costante aumento; pertanto, ciò che caratterizza i big data non è solo la quantità, ma anche la complessità.

Per effettuare una Big Data Analytics è buona norme seguire una serie di steps che partono con l’acquisizione e la comprensione del dato, passano per la modellazione e la previsione, fino alla capacità di prendere decisioni, agendo opportunamente, e monitorando quanto ottenuto in base alle evidenze empiriche riscontrate.

Le aziende per analizzare i Big Data utilizzano tipicamente tecniche di advanced analytics, quali ad esempio analytics di testo, machine learning, predictive analytics, sentiment analysis, data/text mining (esecuzione del cleanup dei dati, di trasformazione dei dati e di creazione dei sistemi per la gestione dei dati), modellazione e apprendimento automatico, per determinare risultati futuri verosimili al fine di prendere decisioni più informate e consapevoli. Risponde alla domanda “perchè”, dando la possibilità di anticipare ciò che con un certo grado di fiducia potrebbe accadere, adottando così in anticipo le modifiche e le soluzioni più opportune, affinché possa essere conseguito un risultato positivo.

In generale, le tecniche di advanced analytics che hanno impatto su tutti i processi aziendali, è possibile classificarle in macrocategorie:

• Descriptive Analytics (analisi descrittive): risponde alla domanda “What happened?”. Nello specifico, si utilizzano tecniche di analisi statistica per suddividere i dati grezzi in una forma che consenta di applicare modelli, identificare anomalie, migliorare la pianificazione e confrontare oggetti compatibili. Le aziende ottengono il massimo valore dall'analisi descrittiva quando la utilizzano per confrontare gli elementi nel tempo o tra di loro, le cui rappresentazioni avvengono tramite appositi grafici.

• Diagnostic Analytics (analisi diagnostica): risponde alla domanda “Why did it happen?” e si caratterizza da tecniche come drill-down, data discovery, data mining, correlazioni, teoria della probabilità, analisi di regressione, analisi di clustering, filtraggio e analisi di serie temporali. Non si tratta solo di statistiche, però. Implica sviluppare il pensiero laterale, nonché considerare fattori interni/esterni che potrebbero influire nella raccoltà dati all’interno dei modelli utilizzati. Infatti, ha come principale obiettivo quello di identificare e spiegare anomalie e valori anomali.

• Predictive Analytics (analisi predittive): risponde alla domanda “What might happen in the future?” e rappresentano il secondo livello di analisi avanzata dei dati. Le analisi predittive, tramite modelli matematici / tecniche di forecasting e machine learning, utilizzano i dati per effettuare un’analisi utile a estrapolare possibili scenari futuri, anticipando cosa potrebbe accadere.

• Prescriptive Analytics (analisi prescrittive): risponde alla domanda “What should we do next?”. Il punto cardine di questa tipologia di analisi è l’associazione tra l’analisi dei dati e la capacità decisionale. L’analisi descrittiva e l’analisi predittiva, insieme a modelli matematici e sistemi di analisi più complessi, permettono di ricavare informazioni puntuali e utili che favoriscono soluzioni operative e strategiche. In questo modo, è possibile adottare decisioni più accurate ed oggettive, basate sui dati, passando dalla “previsione” all’”azione”.

• Automated Analytics (analisi automatizzate): quando si parla di automazione si fa riferimento a soluzioni capaci di implementare autonomamente l’”azione” proposta in base al risultato ottenuto dalle analisi che sono state effettuate. L'automazione nell'analisi dei dati è particolarmente utile quando si analizzano i big data e può essere utilizzata per molteplici attività, come l'identificazione dei dati, la preparazione dei dati, la creazione di dashboard e di specifici report.

Innovare per far crescere l'azienda: un nuovo vantaggio competitivo offerto dai Big Data

L'uso dei Big Data sta diventando una strategia cruciale per le aziende per poter superare i loro competitor. Il vantaggio competitivo che ne deriva si riferisce all’utilizzo di quantità d’informazioni sempre maggiori, attraverso algoritmi capaci di trattare tante variabili in poco tempo e con risorse computazionali ridotte. Non è un caso che i Big Data supportano la raccolta, la classificazione, l’analisi e la sintesi dei dati di un determinato settore, dando la possibilità di ricavare importanti informazioni. La vera rivoluzione dei Big Data è quindi nella capacità di utilizzare grandi quantità di informazioni per elaborare, analizzare e trovare riscontri oggettivi su diverse tematiche della quotidianità aziendale in molteplici mercati di business.

Il segreto non è raccogliere solamente grandi quantità di dati ma essere capaci di analizzarli correttamente in modo tale che possano esprimere al meglio il loro potenziale. In tal senso è importante promuovere la cultura dei dati, perché affinché siano davvero utili alle aziende per i loro obiettivi di business, è necessario definire non solo un piano di raccolta dati, ma un sistema di tecnologie e competenze specifiche che consenta di estrarre da essi il valore che racchiudono.

L’estrazione corretta del loro valore implica una strategia coerente e integrata per la loro gestione, che consenta di ottenere dati affidabili qualora si debbano prendere decisioni basate sui numeri, altrimenti si correrebbe il rischio di attuare azioni di business basate su evidenze empiriche sbagliate, con enormi perdite di tempo nella ricerca degli errori commessi.

Quello che oggi può fare veramente la differenza è la velocità di reazione ai cambiamenti, adeguando tempestivamente le proprie azioni di business alla realtà in continua evoluzione, per poter puntare così al proprio vantaggio competitivo. Tutte le aziende, attraverso una analisi dei dati rapida, in tempo reale, possono riuscire a mettere in atto strategie specifiche e vincenti, in anticipo rispetto ai competitor. L’azienda performante sarà quella che promuoverà la cultura dei dati in ogni reparto, riuscendo ad estrarre il massimo del valore da un’analisi sempre più svelta, intuitiva e veloce.

Inizia la tua trasformazione digitale con SolidRules Quantum!

Tutti i grafici che vi abbiamo mostrato in questo articolo sono stati realizzati con SolidRules Quantum.

Quantum coniuga la trasformazione digitale delle aziende con le più avanzate tecniche di analisi in ambito di Intelligenza Artificiale, Internet of Things (IoT), Machine Learning, Deep Learning e Big Data.

I modi in cui lo stiamo utilizzando internamente sono tantissimi e continuiamo a sperimentarne sempre di nuovi.

Oltre alla domotica aziendale ed edifici intelligenti dei quali abbiamo già parlato in un precedente articolo utilizziamo Quantum anche all’interno della produzione, dove offre un sistema di gestione della fabbrica 4.0, consente di monitorare i dati in tempo reale di tutte le macchine, di correlare tali dati con quelli presenti su SolidRules Desk, analizzando tutte le possibili informazioni ed enfatizzando tutte le possibili criticità e/o opportunità, tramite i propri strumenti di Business Intelligence.

Ovviamente questo è solo un piccolo entrée di tutto quello che potete aspettarvi da Quantum ma soprattutto dal nostro reparto di Ricerca e Sviluppo che in esso ha trovato il suo parco giochi. Se vi interessa approfondire il tema andate alla pagina dedicata a Quantum.

Altro da Alexide

Pronti per l'era dei Big Data?

Gestione dei datiSe DMS, PDM e PLM non sono nel tuo DNA

Gestione dei datiDomande? Siamo qui per te.

Compila il form o invia un'email a info@solidrules.com. Ci metteremo in contatto con te per fornirti tutte le soluzioni.